Fájl környezet egy blog wordpress

A következő hétvégén, és ezért úgy újabb ajánlást, hogy optimalizálja a blog. Ma már SEO-ajánlás - írástudó beállítás robots.txt fájlt.

De először, szeretném emlékeztetni, hogy amellett, hogy az ajánlások, minden héten van tölteni egy ingyenes ellenőrzés egyik blog az olvasók. Meglepő iránti kérelmet, aki olyan szabad ellenőrzés ezen a héten nem küld senkit, így nincs ellenőrzés szintén ingyenes.

Tedd meg most, sőt, a téma a mai ajánlások - írástudó beállítás robots.txt fájlt.

Mi faylrobots.txt és miért van rá szükség?

Mint azt bizonyára tudják, hogy a webhely rangsorban a keresőkben indexelést meg kell indexelt keresés robotok a legtöbb keresőmotorok. Tehát, az első, hogy foglalkozzon, amit a kereső pókok, megy a site - robots.txt fájlt.

Ott látni az eredeti információt a honlapon. Ezért figyelmen kívül hagyja az adatfájl nem szükséges. Éppen ellenkezőleg, azt kell komolyan beállítani ezt a fájlt, annál is inkább, hogy ezt meg kell tenni csak egyszer.

Hogyan hozzunk létre faylrobots.txt és hová tegye?

Mit lehet beállítani vrobots.txt?

A legfontosabb, amit meg kell figyelni, amikor létrehozzák a robots.txt fájl -, hogy utasítsa keresőrobotok mely oldalakat kell indexelni a keresőmotorok index esett csak igazán a céloldalakat.

a) Melyik oldalak webhely indexelt?

Ezen felül, a robotok nem értem, hogy ezek közül számos oldalának jelentős, és kiválasztja a fő nem a kívánt oldalt.

Ezért a feladat, hogy a keresőrobotok nem index oldalak, amelyek ismétlődő tartalmakat.

b) Mi a mappák és fájlok index a szerver?

Nem titok, hogy a WordPress motor elég sok technikai fájlok és mappák. És ha a robot index mindezt, akkor nem lesz felül minden fájl a szerveren, akkor hozzon létre elég sok a kiszolgáló terhelését, hogy egyáltalán nincs rá szükség.

Aztán ott vannak a másik mínusz, ha a robot tudni fogja, hogy mit kell index a webhely, meg kell, például 10 perc és indexelés a szomszédos helyszínen, például, 10 másodperc, és látogasson el a honlapon lesz sokkal kisebb, mint a szomszédos erőforrás . Ez azt jelenti, hogy az új rekordot fog esni az index a keresők hosszú határidővel.

c) Hogyan index a webhely, sWWW vagy anélkül?

Azt hiszem, tudom, hogy a keresők a két helyszínen, készült két különböző helyszínen: VAShSAYT.ru és www.VAShSAYT.ru. Sőt, a kereső érzékeli ezeket a területeket, mint például a másolatok egymást, azaz, mint ugyanazzal a tartalommal.

Persze, egy idő után, a kereső is, hogy saját belátása szerint választhat, hogy melyik ez a két hely a legfontosabb. De ez a választás nem lesz, amit tettél.

Most képzeljük el, hogy Yandex választotta a fő oldalon anélkül, hogy a www, és a Google úgy döntött, hogy www. Ezért szükséges, hogy egyértelműen meg kell határozni a keresőmotorok hogyan index webhelyére.

g) Ha az oldaltérkép a keresőmotorok?

A robots.txt fájl csak meg kell adnia, ahová a sitemap.

Beállítás faylarobots.txt az dvizhkaWordPress

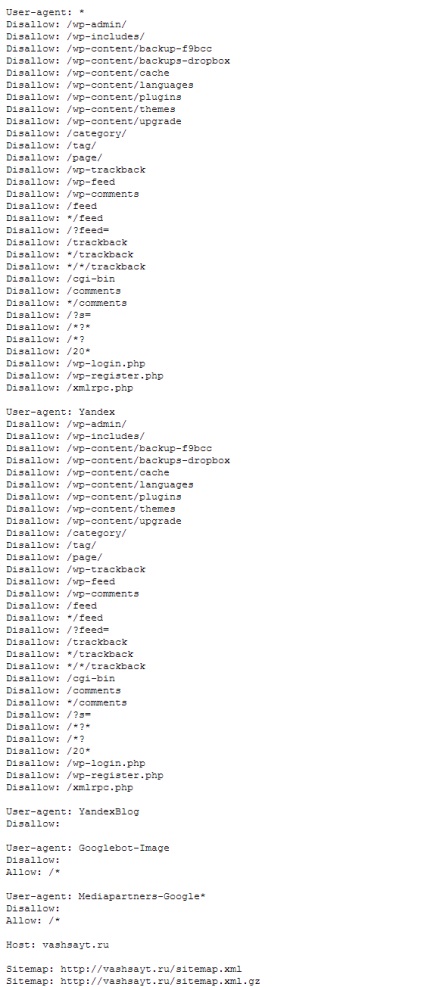

Alul látható a kép által bemutatott kész kódot a robots.txt fájlt a WordPress motort. Figyelembe veszi a javaslatokat, amelyeket a fent tárgyalt. Töltse le a fájlt is, akkor a linkre a kép alatt.

Letöltés létre robots.txt fájlt WordPress:

Letöltéséhez megfelelően konfigurált robots.txt fájlt WordPress, kattintson az egyik a Like gombok: