Hogyan lehet a helyes wordpress, blog internetes tevékenységét, valamint a mindennapi élet maxima

Üdvözlet, kedves olvasók. Ebben a cikkben, azt világosan megmutatja, hogyan lehet a helyes robots.txt. hogy nem rendelkezik semmilyen hibát, amely jelentősen befolyásolja a promóció keresőprogramok, mint a Yandex és a Google. Kezdjük annak érdekében, hogy minden lehetett érteni mindent.

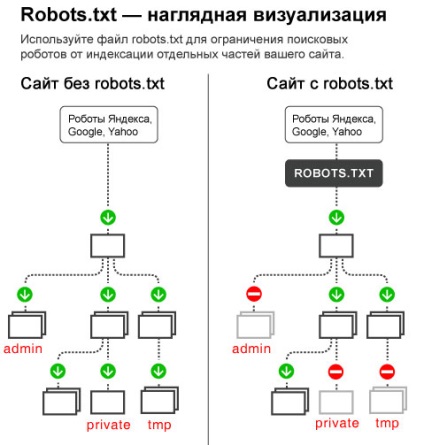

robots.txt - egy egyszerű szöveges megjegyzéseket a gyökere a helyén, amely meghatározza a szabályokat kereső robotok, hogy index, és adja meg az új anyag (oldal) a keresési bázis. A robots.txt akkor mnozhete regisztrálja, hogy lehet indexelni a honlapon, és mit nem.

Azt találtuk, hogy ez nagyon fontos megállapítani az elején, hogy hozzon létre egy blogot. mert ha nem teszed minden erőfeszítést mehet hamu, és a webhely lesz tilalmat a keresőkben. Ha ez megtörténik, akkor az oldal fejlesztése nem lesz többé semmi értelme, mert a kiadási oldalon a tilalmat, amely egyébként is nevezik a szűrő AGS nagyon nehéz lesz. A gyakorlatban kevesen tudtak, hogy vonja vissza az oldalra AGS kevesebb, mint egy éve.

Továbbá, ráadásul páros kell zárni az index és más oldalakat, amelyek nem az érdeklődés és az érték, mind a keresőmotorok és a látogatók. Például az admin a blog oldalt, ahol megadhatja a felhasználónevét és jelszavát, hogy megy a blog. Azt hiszem, nem igazán ragadtatva, ha egy nap látni az átmenet Statisztikai valaki gyakran jön hozzád az oldalakon próbálják feltörni, és így lopni tőled a gyermek.

Nos, én minden rendben lesz többé megijeszteni, és akkor valószínűleg már kezdett szemmel rándulás a félelem, hogy az itt leírtak ^ _ ^. Csak nézd meg az alábbi képre, hogy jobban megértsük, mi teszi ezt a fájlt.

Hogyan készítsünk egy helyes robots.txt WordPress?

1) Tedd a desktop file, amely az úgynevezett egy notebook, és nevezze meg robots.txt. Szeretném megjegyezni, hogy bizonyos, hogy egy baklövés hívja robots.txt fájlt vagy robot.txt. Nézd meg alaposan, hogyan nevezze el a fájlt, majd a keresőrobotok egyszerűen figyelmen kívül hagyja azt, hogy elkerülhetetlenül vezet, mint már említettük, hogy a szűrő AGS.

2) Most ki kell töltenie ezt a fájlt, hogy van, ez biztosítja a szabályok botok nevezzük könyvtárakat.

1) Az első könyvtár, amelynek meg kell kezdeni a robots.txt fájl a User-agent. Azt válaszolja, amely végrehajtja a parancsot a robot egy adott kereső, amelyet az alábbiakban ismertetjük. Például, ha azt szeretnénk, hogy ez a szabály írja elő minden keresőrobotok, meg kell adni a végén egy csillag.

Ha azt szeretnénk, hogy ezek a szabályok betartását csak a keresőrobotok Google, regisztrálnia kell a Google bot elnevezése helyett egy csillag.

Példa: User-agent: Googlebot

Itt van, az úton, a nevek a botok népszerű keresőmotorok.

Keresők. A keresőmotor pókok.

A mi esetünkben fog felírni két könyvtár. Az egyik az összes keresők és egy Yandex, mert egy szörnyen szeszélyes és különleges figyelmet igényel.

2) A robots.txt van két fontos könyvtárakat. Az első engedélyezése, amely lehetővé teszi a bot index és a Disallow, amely megtiltja az index. Bármelyiket is voltak robots.txt ez szükségképpen legalább egy tiltása könyvtár ellentétben engedélyezése, majd a robots.txt rossz.

Valójában lehetséges, hogy nem használja a könyvtárat Hagyjuk, mert segítségével a könyvtár tiltása akkor nem csak közeli, hanem, hogy nyissa ki az indexelő robot. Nézd, ha azt írják, így a mi robots.txt könyvtárak, akkor mi robotunk számára index az egész blog Yandex.

User-agent: *

Letiltás:

De ha tesz egy kötőjel / utáni tiltása: megtiltjuk a blog index Yandex.

User-agent: *

Disallow: /

Néhány webmester lezárja a forrás a Yahoo bot, mert van egy speciális panel, amely akkor éget (lásd) linkek, melyek más oldalakon. Ez azt jelenti, lehet, hogy vizuálisan meghatározni a számát és minőségét kapcsolatokat kell vásárolni, hogy ugyanazt az eredményt, mint a versenytárs site.

Ezért sok előírt további címtár Yahoo, így nem indexeli az élet és egyúttal nem lőtt uraik (linkek), ami az oldalon. Ha Ön is szeretné, hogy lezárja az indexelés a Yahoo, majd írjuk be a robots.txt következő sort:

3) Most kell zárni az oldalakat, amelyek közvetlenül kapcsolódnak a motor WordPress.

Disallow: / wp-login.php

Letiltás: /wp-register.php

Disallow: / webstat /

Disallow: / wp-content / themes

Disallow: / wp-content / plugins

Disallow: / wp-content / nyelv

Disallow: / wp-content / cache

Disallow: / wp-admin /

Disallow: / wp-includes /

A wp-content mappában nincs semmi értékes, kivéve a képeket, amelyek ellen a feltöltések ezért külön előírt szabályokat az összes mappát, amelyek a wp-content. Ha a mappa wp-content még mindig van a mappák szkriptek, vagy valami más, jobb, ha megnézi, hogy nem jeleníti meg azt is előírja ezt a mappát a robots.txt fájlban.

4) Most zárja be az oldalt, hogy bennünket megduplázódik.

sitemap.xml - térkép a webhely a keresőmotorok, amely sokat segít gyorsabban index webhelyére. Ez a kártya lehet tenni a plugin egyszerű Google Sitemap, vagy ezen az oldalon. Ha ezt a mysitemapgenerator.com, miután tett egy térképet sitemap.xml szüksége lesz rá később, hogy dobja a gyökér a blog.

6) Itt egy példa arra, hogyan néz ki a megfelelő robots.txt fájlt WordPress. Csak ne másolja maguknak, úgyhogy majd csak megmagyarázni, mi az oldal miért felelős.

Hogyan lehet ellenőrizni a robots.txt hibákat?

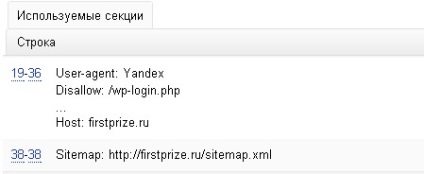

4) Miután regisztrált az összes könyvtárat a robots.txt fájlt feltölteni, hogy a gyökér a webhelyen keresztül FTP program a httpdocs mappa (vagy public_html. Www, domének). Ezután kattintson a linkre Yandex Webmaster panel, és menj a „indexelés beállításai”, „elemzése a robots.txt”. Most egyszerűen kattintson a „Feltöltés robots.txt a helyén”, majd „ellenőrizni”. Ha megjelenik a következő sorokat, akkor van a megfelelő robots.txt.

Ok, most ugyanaz a csekket a Google itt. Menj a „scan”, majd „blokkolt URL”, és nyomja meg a „check”. Itt is ad a Google információért, mint Yandex, hogy a robots.txt fájl lesz hibákat. Nos, van például, ha te írtad Disllow helyett tiltása.

Miután megváltoztattuk a robots.txt a beállítások nem azonnal életbe lép, de ha újra eljön keresni bot és akarat index ismét a fájlt, majd meg kell várni egy kicsit frissíteni a SERPs (1-3 hónap).

Ez minden. Ha további kérdése van, hogyan lehet egy megfelelő robots.txt WordPress, akkor kérje meg, hogy ide.